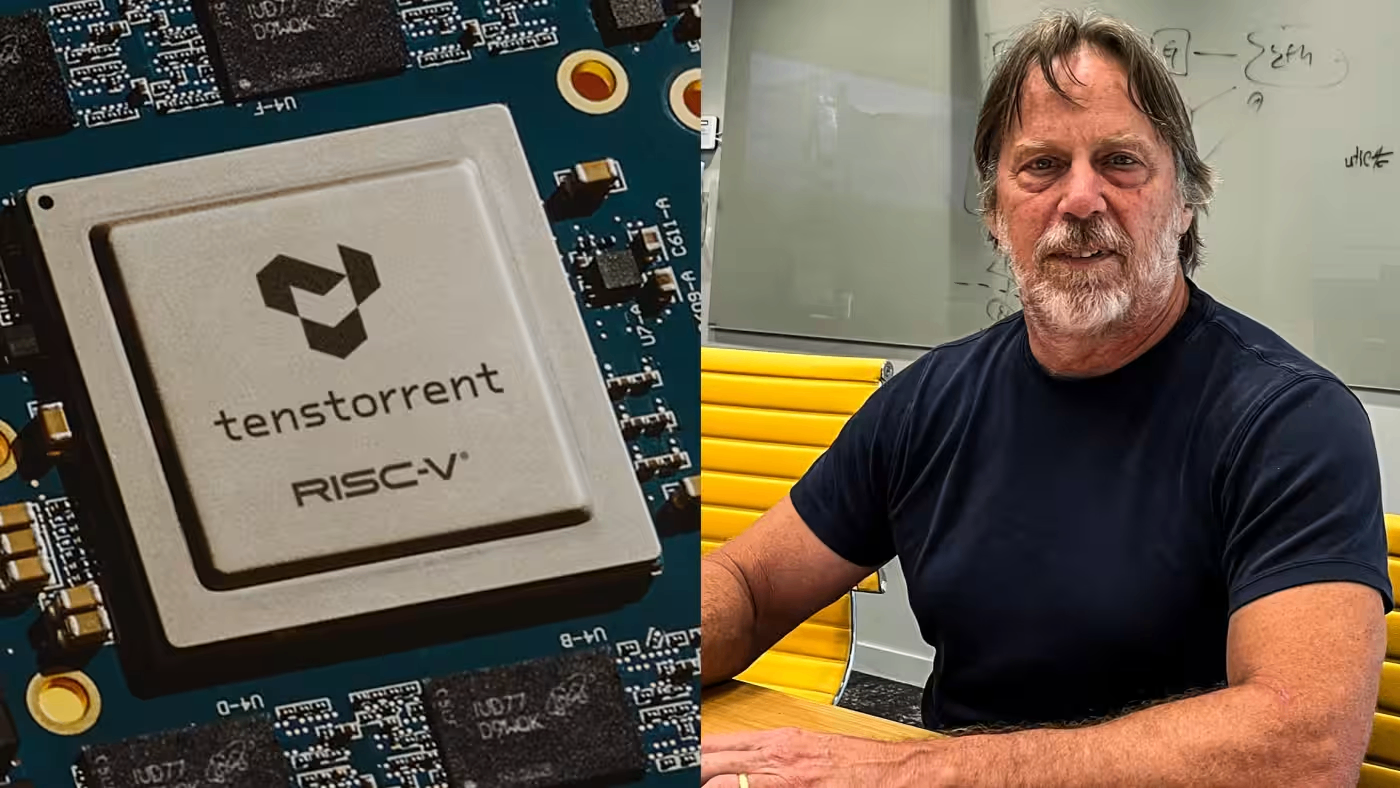

CEO của Tenstorrent, Jim Keller, rất nổi tiếng trong giới thiết kế chip. (Ảnh của Ryotaro Yamada)

TOKYO -- Jim Keller, một nhà thiết kế chip từng làm việc cho Intel, AMD và Tesla, đang cố gắng giảm giá các ứng dụng AI bằng cách thiết kế các chip hiệu quả hơn so với Nvidia, với mục tiêu giành được một phần thị trường do gã khổng lồ Mỹ nắm giữ.

"Có nhiều thị trường chưa được Nvidia phục vụ tốt," Keller, hiện là CEO của Tenstorrent, một startup của Mỹ chuyên thiết kế chip AI, cho biết.

"Với việc sử dụng AI mở rộng sang điện thoại thông minh, xe điện và dịch vụ đám mây, nhiều công ty đang tìm kiếm các giải pháp rẻ hơn," ông nói, và thêm rằng "có rất nhiều công ty nhỏ không muốn trả 20.000 đô la" cho các đơn vị xử lý đồ họa (GPU) cao cấp của Nvidia, vốn được coi là lựa chọn tốt nhất trên thị trường.

Keller nổi tiếng trong giới thiết kế chip vì là nhà thiết kế chính của dòng chip Zen của AMD, mà nhiều người tin rằng đã giúp AMD phục hồi sau khi gặp khó khăn trong việc cạnh tranh với Intel vào cuối những năm 2010. Ông cũng là một nhân vật quan trọng trong việc phát triển các chipset cho Autopilot, phần mềm lái tự động của Tesla.

"Ông là một huyền thoại," Junichiro Makino, trưởng nhóm thiết kế chip tại công ty AI Nhật Bản Preferred Networks, cho biết.

Tenstorrent, thành lập vào năm 2016, đang chuẩn bị phát hành chip AI đa năng thế hệ thứ hai của mình vào cuối năm nay. Công ty cho biết rằng ở một số lĩnh vực, chip của họ có hiệu suất năng lượng và xử lý tốt hơn so với GPU AI của Nvidia. Theo Tenstorrent, hệ thống Galaxy của họ hiệu quả gấp ba lần và giá rẻ hơn 33% so với DGX của Nvidia, một máy chủ phổ biến được sử dụng cho AI.

Jim Keller nói rằng một trong những lý do điều này có thể xảy ra là do công ty không sử dụng bộ nhớ băng thông cao (HBM), loại chip bộ nhớ tiên tiến phổ biến có khả năng truyền dữ liệu lớn nhanh chóng. HBM là thành phần quan trọng cho các chip AI sinh sản và đã đóng vai trò quan trọng trong thành công của Nvidia.

Tuy nhiên, HBM cũng là một trong những nguyên nhân gây ra tiêu thụ năng lượng lớn và giá cả cao của các chip AI.

"Ngay cả những người sử dụng HBM cũng gặp khó khăn với chi phí và thời gian thiết kế để xây dựng nó," Keller nói thêm, cho biết ông đã đưa ra quyết định kỹ thuật để không sử dụng công nghệ này.

Trong một chipset AI điển hình, GPU gửi dữ liệu đến bộ nhớ mỗi khi một quy trình được thực hiện. Điều này đòi hỏi khả năng truyền dữ liệu tốc độ cao của HBM. Tuy nhiên, Tenstorrent đã thiết kế đặc biệt chip của mình để giảm đáng kể các truyền dữ liệu như vậy.

Keller nói rằng với phương pháp mới này, thiết kế chip của công ty có thể thay thế cả GPU và HBM trong một số lĩnh vực phát triển AI.

Công ty cũng đang thiết kế sản phẩm của mình để "có giá thành hợp lý nhất có thể," ông nói. Ông cũng cho biết nhiều công ty khác trong lĩnh vực cũng đang tìm kiếm một giải pháp bộ nhớ tốt hơn, nhưng ông cũng thừa nhận rằng sẽ mất nhiều năm để xáo trộn ngành công nghiệp HBM "to lớn" hiện tại.

Thay vì một công ty thay thế Nvidia, Keller dự đoán rằng sẽ xuất hiện nhiều nhà sản xuất mới hơn để điền vào nhiều thị trường AI khác mà công ty Mỹ này chưa phục vụ được.

Đặc điểm quan trọng của vi mạch của Tenstorrent là các CPU nhỏ trong mỗi hơn trăm lõi của nó, những bộ não nhỏ nằm trong một bộ não lớn.

Thông thường, một lõi chip đơn lẻ chỉ có một máy tính nhỏ và bộ nhớ, chỉ đảm nhận giải quyết một nhiệm vụ cụ thể. Tuy nhiên, các lõi của Tenstorrent sẽ có khả năng "suy nghĩ" tự do, quyết định xử lý dữ liệu nào trước và liệu có nên từ bỏ một số nhiệm vụ nếu chúng được xem là không cần thiết, từ đó nâng cao hiệu quả tổng thể.

Bởi vì mỗi lõi khá độc lập, công ty cho biết vi mạch có thể được điều chỉnh cho một loạt ứng dụng rộng hơn bằng cách xếp chồng nhiều hoặc ít lõi lại với nhau. Ví dụ, một số lượng nhỏ có thể đủ cho điện thoại thông minh hoặc thiết bị đeo được, trong khi 100 lõi có thể được kết hợp để sử dụng trong các trung tâm dữ liệu AI.

Sự linh hoạt như vậy là quan trọng vì các chủ đề về cách phát triển AI và việc sử dụng nó vẫn còn mở để tranh luận.

Keller nói rằng không thể dự đoán được ứng dụng tốt nhất cho AI sẽ là gì. "Hôm nay tôi không thể nói điều này sẽ lớn hay nhỏ hơn. Vì vậy, chiến lược của chúng tôi là xây dựng một công nghệ phù hợp với một loạt các sản phẩm," ông nói.